Cache

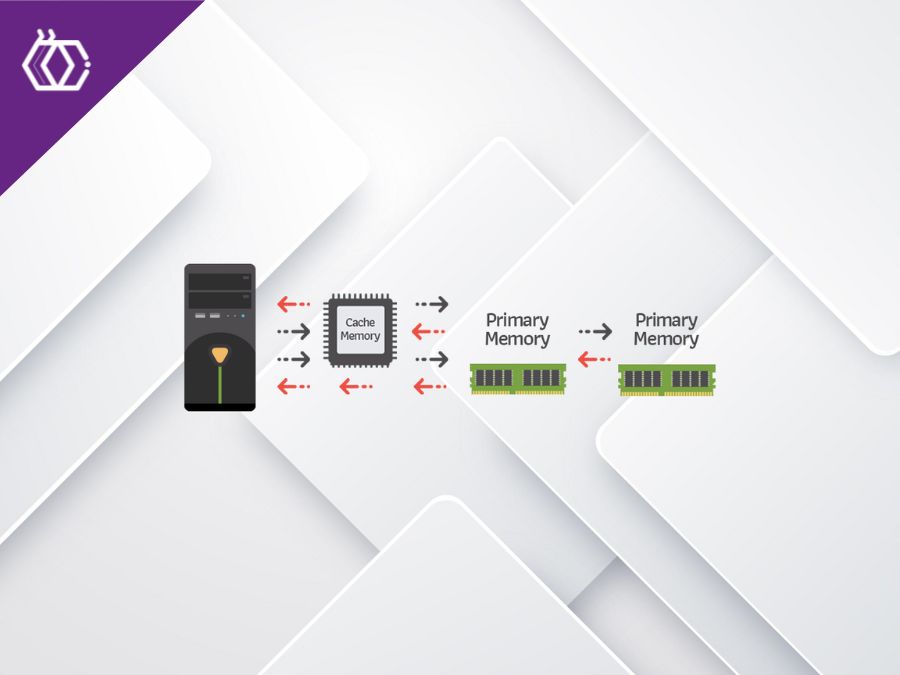

(6 minutos de leitura) A otimização de desempenho é uma preocupação constante para devs de software, e um dos elementos-chave nesse contexto é a memória cache. Compreender como a memória cache funciona e como utilizá-la eficientemente pode ter um impacto significativo na velocidade e eficiência de um programa. Vamos explorar esse conceito crucial para o desenvolvimento de software. O QUE É MEMÓRIA CACHE? A memória cache é um tipo de memória de acesso rápido e temporário que fica localizada entre a unidade central de processamento (CPU) e a memória principal (RAM) de um computador. Seu principal propósito é armazenar dados temporariamente para reduzir o tempo de acesso a esses dados pela CPU. Quando um programa é executado, ele acessa continuamente dados na memória RAM. A memória cache atua como uma camada adicional de armazenamento que contém cópias dos dados mais frequentemente utilizados ou esperados. Isso é feito para evitar que a CPU tenha que buscar constantemente dados na memória principal, que é mais lenta em comparação com a memória cache. A memória cache é organizada em níveis, geralmente referidos como L1, L2 e L3, cada um com diferentes níveis de proximidade com a CPU e capacidade de armazenamento. Ao utilizar a memória cache, os dados frequentemente acessados podem ser recuperados mais rapidamente, melhorando significativamente o desempenho geral do sistema. A eficácia da memória cache reside na exploração dos princípios de localidade temporal (reutilização de dados recentes) e localidade espacial (acesso a dados próximos aos já utilizados). Esses princípios ajudam a minimizar o impacto dos tempos de acesso mais lentos da memória principal. TIPOS DE MEMÓRIA CACHE Existem geralmente três níveis de cache (L1, L2 e L3), cada um com diferentes tamanhos e proximidades à CPU. Quanto mais próximo da CPU, menor é o tamanho da cache, mas o acesso é mais rápido. Abaixo detalharemos cada uma delas: L1 Cache: A mais rápida e próxima da CPU, geralmente dividida entre cache de instruções (código) e cache de dados. L2 Cache: Fica entre a L1 e a memória principal, oferecendo um equilíbrio entre velocidade e capacidade. L3 Cache: Compartilhada entre os núcleos da CPU, fornece uma reserva maior de dados com um tempo de acesso um pouco mais lento. VANTAGENS DE UTILIZAR MEMÓRIA CACHE São muitas as vantagens em usar memória cache, abaixo listamos algumas das principais. Rapidez no Acesso: Acesso mais rápido a dados frequentemente utilizados, reduzindo a latência. Redução do Tráfego na Memória Principal: Diminui a carga na memória principal, evitando gargalos no sistema. Economia de Energia: O acesso rápido à cache permite que a CPU entre em estados de baixo consumo de energia com mais frequência. DICAS PARA OTIMIZAÇÃO Padronização de Acesso: Aproveite a localidade temporal e espacial, acessando dados próximos no tempo e espaço para maximizar o benefício da cache. Minimização de Conflitos: Evite padrões de acesso que resultem em conflitos de cache, o que pode diminuir a eficiência. Tamanho Adequado: Escolha o tamanho de cache apropriado para a aplicação. Tamanhos maiores nem sempre significam melhor desempenho. Perfil de Uso: Analise o padrão de acesso aos dados da sua aplicação e ajuste a estratégia de cache de acordo. A memória cache desempenha um papel crucial na otimização do desempenho dos sistemas. Compreender como ela funciona e aplicar estratégias eficientes de uso pode resultar em melhorias substanciais na velocidade e eficiência dos seus aplicativos. Esteja atento ao perfil de acesso aos dados e ajuste sua abordagem de cache conforme necessário para obter o máximo benefício.

Compartilhe este artigo em suas redes sociais:

Avalie este artigo:

[yasr_visitor_votes size=”medium”]